A/B-Tests gelten zu Recht als wertvolles Instrument der Conversion-Optimierung. Insofern ist der noch immer existente Hype um sie verständlich. Allerdings besitzt nicht jedes Unternehmen in gleichem Maße Kapazitäten, um solche Tests richtig durchzuführen. Und falsch durchgeführt, wird aus dem gehypten Instrument schnell ein Flop. Deshalb nutzt man bisweilen besser Alternativen. Hierbei kommt etwas erneut ins Spiel, was aus Sicht mancher Expertinnen eigentlich durch A/B-Tests ersetzt werden sollte: Best Practice.

Viele Expertinnen waren vor nicht allzu langer Zeit der Ansicht, dass eine Website-Optimierung ohne A/B-Tests nicht mehr zeitgemäß ist. Best-Practice-Beispiele und Experten-Meinungen eigneten sich aus ihrer Sicht nur noch als Anregung für Testideen. Gebrochen scheint der Hype rund um A/B-Tests bis heute nicht zu sein. Und natürlich gibt es gute Gründe, sie als Instrument der Website-Optimierung zu lieben. Aber nicht vorbehaltlos.

Warum? Der Aufwand einer Website-Optimierung mit dem Testverfahren kann so groß sein, dass die Ressourcen kleinerer Unternehmen dafür nicht ausreichen. Niemand sollte sich dann selbst belügen: Mit guten Testing-Tools zu testen, ist zwar einfach. Mit ihnen so zu testen, dass valide Ergebnisse dabei herauskommen, ist oft deutlich schwieriger. Welchen Stellenwert soll man den Tests also zusprechen?

Marketerinnen lieben A/B Tests. Immer noch. Immer mehr.

72 Prozent der in einer Studie aus 2017 befragten Marketer in Unternehmen bescheinigen A/B-Tests, ein „highly valuable” (hoch wertvolles) Instrument zu sein. Das bedeutet einen Anstieg um zwölf Prozentpunkte seit 2016.

Bei der Studie handelt es sich um den Conversion Rate Optimization Report 2017, der von den Unternehmen Econsultancy und RedEye herausgebracht wurde. Für die Studie haben die Autorinnen Mitarbeiterinnen von Unternehmen und Agenturen befragt, die ihre Conversion-Rate verbessern möchten beziehungsweise Unternehmen bei der Optimierung unterstützen. Die Studie aus 2017 war bereits die neunte des jährlich herausgebrachten Reports. Und sie lieferte weitere Ergebnisse, von denen wir hier kurz einige vorstellen.

- Laut Aussage der befragten Agentur-Mitarbeiterinnen stufen sechzig Prozent der Agenturkundinnen A/B-Tests als „highly valuable” Instrument ein.

- Je komplexer das Testing ist, desto wahrscheinlicher sind verbesserte Conversion-Raten.

- Bei 65 Prozent der Befragten werden A/B-Tests eingesetzt, um die Conversion-Rate zu steigern. Damit sind A/B-Tests vor der Customer-Journey-Analyse (61 Prozent) das am häufigsten eingesetzte Instrument zur Steigerung der Conversion-Rate.

Es ist alles so einfach. Scheinbar.

Mit modernen A/B Testing Tools werden A/B Tests ganz einfach. Im WYSIWYG (What you see is what you get) Verfahren können Nutzer*innen problemlos und schnell Testvarianten von Internetseiten erstellen. Sie können dafür Seitenelemente verändern, weglassen oder hinzufügen. Auf diese Weise erhalten sie neben der Originalvariante die veränderte Testvariante. Beide integrieren sie anschließend in einen A/B Test und schauen, welche Variante zu mehr Conversions führt. Die Siegervariante setzen sie künftig weiter im Internet ein und nutzen sie für weitere Optimierungen. Fertig.

Warum alles doch nicht so einfach ist

Tatsächlich ist das der grobe Ablauf eines Tests. Aber er lässt natürlich einiges aus. Wichtig ist die Frage der Signifikanz von Testergebnissen. Vereinfacht ausgedrückt, ist ein Testergebnis signifikant, wenn es mit hoher Wahrscheinlichkeit nicht zufällig entstanden ist. Signifikanz ist deshalb wichtig, weil man bei einem Test mit einem nicht signifikanten Ergebnis im ungünstigen Fall einen falschen Sieger kürt. Und dann könnte es sein, dass die Optimierung die Leistung der Internetseite tatsächlich verschlechtert.

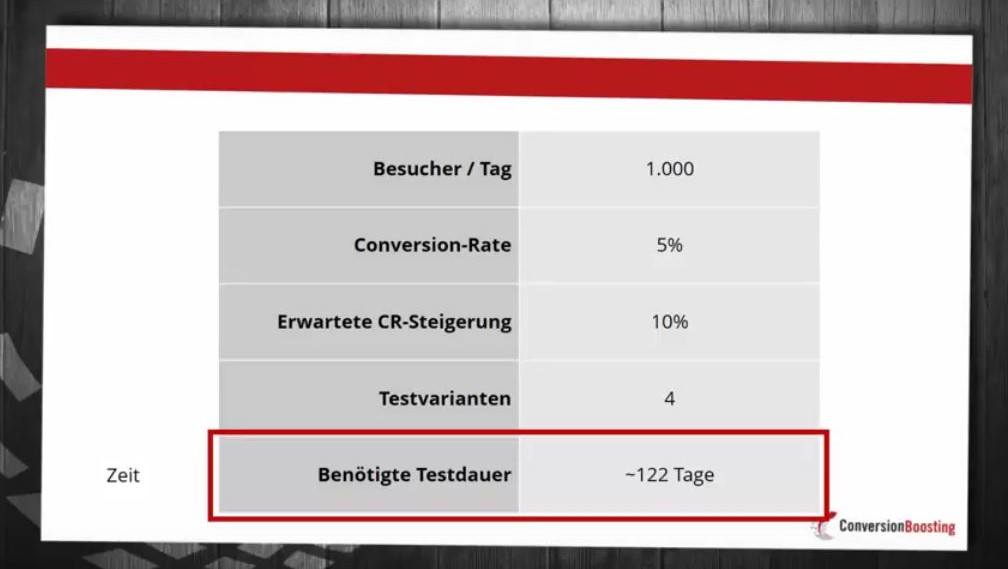

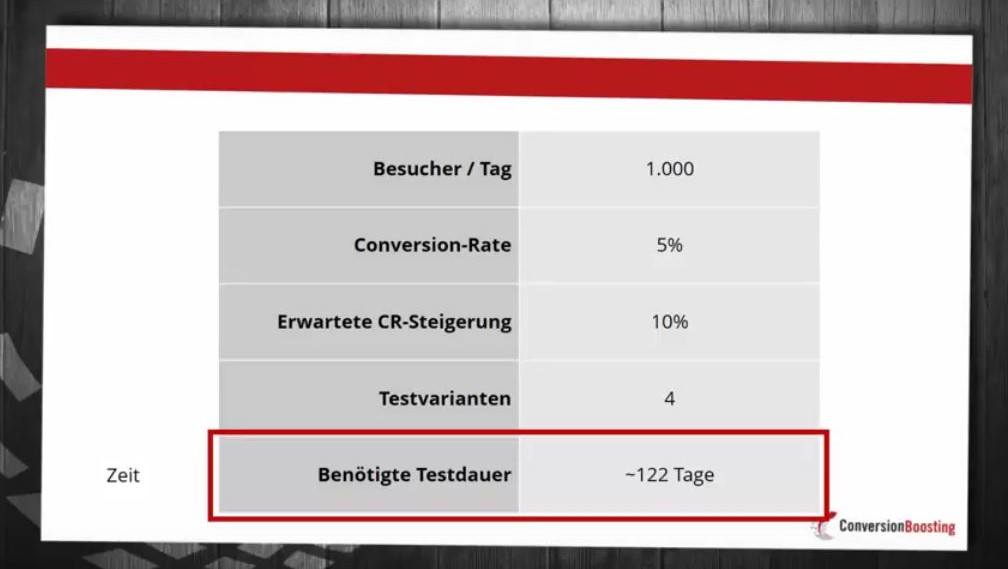

Um signifikante Testergebnisse zu erhalten, ist unter anderem eine bestimmte Menge an Testteilnehmer*innen nötig. Wie hoch die Zahl konkret ist, hängt von den anderen Einflussfaktoren ab. Oft ist sie aber so hoch, dass viele A/B Tests auf trafficarmen Websites sehr lange laufen müssten, um valide Ergebnisse zu erzielen.

Das bedeutet nicht, dass A/B-Tests mit wenig Traffic komplett auf Testings verzichten müssen. ConversionBoosting zeigt im kostenlosen Webinar A/B-Testing mit wenig Traffic – und trotzdem viel Erfolg, wie Besitzer solcher Seiten vorgehen können.

Der Aufwand des Testings steigt aber noch aus einem anderen Grund. Wirklich effizient ist nur ein planvolles Testing. Das bedeutet: Für gute A/B-Tests benötigt man erst einmal gute Hypothesen, die durch die Tests geprüft werden. Unterscheiden muss man dabei zwischen groben Testideen, allgemeinen und konkreten Hypothesen. Ein Beispiel:

- Testidee: Die Absprungrate im Onlineformular zur Registrierung als Bestandskunde ist hoch. Wir müssen testen, wie sie sich senken lässt.

- Allgemeine Hypothese: Bei manchen Feldern des Onlineformulars bleibt unklar, was Nutzer dort wie eintragen sollen.

- Konkrete Hypothese: Integriert man kleine Infobuttons neben die Felder des Onlineformulars, über die ein Nutzer Informationen zum geforderten Eintrag abrufen kann, brechen weniger Menschen den Registrierungsprozess ab.

Erst die konkrete Hypothese ist diejenige, die sich mit einem A/B Test sinnvoll überprüfen lässt. Wie man solche Hypothesen findet, verrät der ConversionBoosting Praxisguide Hypothesen und Testideen im Unternehmen finden. Weitere Ideen enthält der Praxisguide Gute Hypothesen für A/B-Tests aufstellen. Wie die Webinare sind die Praxisguides kostenlos.

Gutes Testing ist kontinuierliches Testing

Die Praxisguides und Webinare von ConversionBoosting zeigen zwar, dass A/B-Testing nicht zwangsläufig Großunternehmen vorbehalten sein muss. Allerdings sollte jedem*r Unternehmer*in bewusst sein, dass es nicht mit einigen Tests getan ist, deren Testideen aus dem Bauch heraus entwickelt wurden.

Gute A/B Tests bedürfen einer intensiven Vorbereitung, in der brauchbare Hypothesen gebildet werden. Sie müssen wissenschaftlichen Kriterien genügen. Und man sollte hinterher nicht einfach die siegreiche Seitenvariante küren. Zusätzlich sollte man feststellen, welche Schlüsse sich aus dem Testergebnis ziehen lassen und welche Folgetests sinnvoll sein könnten. Gutes Testing ist kontinuierliches Testing. Berücksichtigt man auf dieser Basis den Gesamtaufwand der A/B-Tests, wird sich bei manch einem kleineren Unternehmen zeigen, dass Testings für sie nicht die effizienteste Methode der Website-Optimierung sind.

Best Practice kann mehr sein als nur Ideengeber

Als A/B-Tests immer populärer wurden, verdrängten sie ein Stück weit Best-Practice-Beispiele als Basis einer Website-Optimierung. Dieser Prozess führte bis zur bisweilen vertretenen Extremmeinung, dass solche Beispiele komplett überflüssig sind.

Vertreter dieser Meinung sehen in jeder Website einen eigenen und einmaligen Mikrokosmos. Er ist ihrer Meinung nach so sehr von individuellen Kennwerten wie der Besucherzahl, der Besucherstruktur und dem Besucherverhalten geprägt, dass Beispiele von anderen Websites nicht übertragbar sind. Diese Meinung ist mit Sicherheit nicht völlig falsch, aber wohl übertrieben.

Best-Practice hat nach wie vor seinen Wert. Allerdings muss klar sein, welche Art von Best-Practice gemeint ist. Natürlich können sich Unternehmer*innen erfolgreiche Websites der Konkurrenz ansehen, um einiges zu kopieren. Natürlich können sie Fallstudien lesen und ihre Schlüsse daraus ziehen. Der subjektive Anteil der Entscheidungen ist hier jedoch relativ groß.

Weitaus besser ist es, sich bei der eigenen Optimierung an Grundsätzen einer Website-Optimierung zu orientieren, die den Erfolg einer Internetseite nachweislich steigern. ConversionBoosting nennt solche Grundsätze „Heuristiken“. Sie basieren auf den Ergebnissen vieler A/B-Tests und sind damit Best-Practice-Vorschläge, die auf einer breiten Datenbasis gebildet wurden. Das unterscheidet sie von klassischen Best-Practice-Beispielen.

ConversionBoosting nutzt Heuristiken in seinem Analyse-Tool ANALYZE, um Nutzer*innen konkrete Vorschläge für die Optimierung ihrer Internetseite zu geben. ANALYZE bietet damit eine Möglichkeit, von A/B-Tests zu profitieren, ohne selbst A/B-Tests durchzuführen.

Dadurch belegt ANALYZE, dass A/B-Tests wichtig für eine gute Seitenoptimierung sind. Der Hype um sie ist also weiterhin gerechtfertigt. Aber ANALYZE verhindert, dass der individuelle Einsatz von A/B-Tests mangels nötiger Ressourcen und aufgrund eines fehlerhaften Einsatzes bei manch einem*r Unternehmer*in zum Flop wird. SO wird ANALYZE zu einer nützlichen und sehr sinnvollen Ergänzung klassischer A/B-Testing-Tools.

Der Autor

Julian Kleinknecht

Geschäftsführer & Gründer

Julian Kleinknecht hat viele Jahre Erfahrung in den Bereichen Web-Analyse und A/B-Testing und teilt sein Wissen oft bei LinkedIn.

- 68 Seiten Conversion-Wissen gedruckt oder digital

- Kostenlos per Post oder als Download