Kameleoon (Testing-Tool-Anbieter) und ConversionBoosting haben jüngst in einem aktuellen, kostenlosen Webinar einmal besonders häufige Fehler bei A/B Tests vorgestellt. Wer sie vermeidet, testet erfolgreicher. Fünf der Fehler präsentieren wir in diesem Artikel.

A/B Tests sind das mächtigste Instrument der Conversion-Optimierung. Damit es optimal funktioniert, muss man planvoll testen und Regeln der Statistik beachten. Das ist allerdings nicht immer ganz einfach. Fehler sind möglich, die die Effizienz des Testings stark beeinträchtigen oder die Tests gar verfälschen.

Einige dieser Fehler geschehen besonders häufig. Kameleoon und ConversionBoosting haben sich deshalb für das gemeinsame Webinar „Die 7 größten Fehler bei A/B-Tests – die Sie garantiert schon einmal selbst gemacht haben!“ entschieden, in dem sie alle TeilnehmerInnen vor solchen Fehlern warnen. Die folgenden fünf Fehler stellen wir auch hier im Artikel vor.

1) Der erste Test ist viel zu komplex

Wer mit A/B Testing in einem größeren Unternehmen beginnt, hat mit an Sicherheit grenzender Wahrscheinlichkeit Skeptiker in der Firma, die den Sinn der Tests bezweifeln. Oft gehören einige davon zur Geschäftsleitung. Solche Menschen sollte man möglichst sofort mit den ersten Testergebnissen überzeugen, ansonsten war der erste Test möglicherweise zugleich der letzte.

Viele Tester berücksichtigen das nicht. Sie diskutieren lange im Team über mögliche Testideen und entwerfen für den ersten Test schließlich ein viel zu komplexes Szenario. Bei solchen Szenarien ist das Risiko hoch, dass während des Testens Schwierigkeiten auftauchen oder dass eher unscheinbare Ergebnisse herauskommen. Das sollte in späteren Phasen des Testings kein Grund sein, auf solche Testszenarien zu verzichten. Beim ersten Test geht es aber um Überzeugungsarbeit und da sind sie denkbar ungeeignet.

Der erste Test sollte einfach konzipiert sein, reibungslos laufen und möglichst große Chancen auf schnelle, eindrucksvolle Ergebnisse (Quick Wins) bieten. Dann bringt er Kritiker zum Schweigen und legt den Grundstein für eine langfristige Optimierung der Website oder des Onlineshops.

2) Es wird ohne Hypothese getestet!

Tests, die aus dem Bauch heraus entstehen, können natürlich zufällig deutlich gesteigerte Conversion-Raten bringen. Testing wird damit jedoch zu einem Glücksspiel, bei dem nur im besten Fall eine höhere Conversion-Rate herausspringt. Was dagegen niemals erreicht wird, sind Erkenntnisse, die sich für weitere Optimierungen nutzen lassen. Dabei sind sie ein ebenso wertvoller Gewinn wie die steigende Conversion-Rate. Deshalb: Erst Hypothesen bilden und dann die Hypothesen mit dem Testing überprüfen.

3) Die falschen Testideen werden priorisiert

Oft sind nicht zu wenige Testideen beim Testing das Problem, sondern zu viele. Jeder ins Testing involvierte Mitarbeiter bringt eigene Ideen ein und hat vielleicht Kontakt zu jeweils anderen Mitarbeitern, die wiederum eigene Testideen entwickeln. Und dann gibt es bei einem Onlineshop vielleicht eine Vielzahl an Ideen für eine Optimierung der Startseite, der Kategorie- oder Produktdetailseiten, der seiteninternen Suchmaschine, des Checkouts und der Produktfilter …

Natürlich kann man sich für die Idee desjenigen entscheiden, der am lautesten „hier“ schreit. Aber das ist nicht die beste Option. Grundsätzlich rät Kamal Karim dazu, eine Seite von hinten nach vorn zu optimieren. Das würde beim Onlineshop etwa bedeuten, dass man beim Checkout beginnt.

Für eine Priorisierung aller Testideen empfiehlt er den Blick auf Testideen aus den Blickwinkeln „Performance“, „Umsetzung“ und „Relevanz“. Konkret geht es dabei um die folgenden Fragen:

- Welchen Einfluss könnte die Testidee auf die Performance der Website haben (z.B. auf den Anzahl der Verkäufe oder den Umsatz)?

- Wie einfach lässt sich die Testidee umsetzen?

- Wie gut lässt sich die Testidee datenanalytisch begründen? Gibt es Daten, die die Wichtigkeit der Testidee untermauern?

Als mögliche Antworten auf diese Fragen definiert man eine Skala von 1 bis 10, also von „sehr schlecht“ bzw. „sehr gering“ (Einfluss auf Performance) bis „sehr gut“ bzw. „sehr hoch“. Die Bewertungen kann man in einer Priorisierungstabelle dokumentieren.

In die Tabelle werden die Testideen eingetragen. Zusätzlich enthält sie Infos, für welche Devices die Tests gedacht sind (Mobile? PC?) und welche Seitenbereiche sie betreffen. Die jeweiligen Bewertungen zu „Performance“, „Umsetzung“ und „Relevanz“ werden addiert und ergeben am Ende eine Gesamtranking-Zahl.

Am besten lässt man diverse Tabellen durch Vertreter verschiedener Gruppen erstellen und entwickelt daraus das Gesamtergebnis. Schließlich haben beispielsweise externe Berater einen anderen Blickwinkel als die hausinterne Marketingabteilung und jede Perspektive hat ihren Wert.

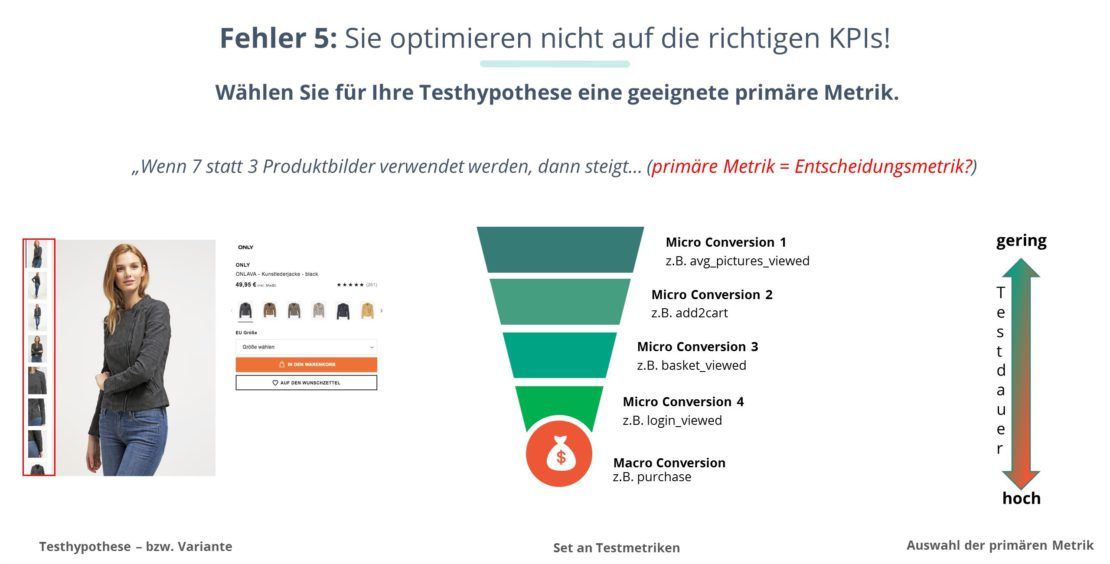

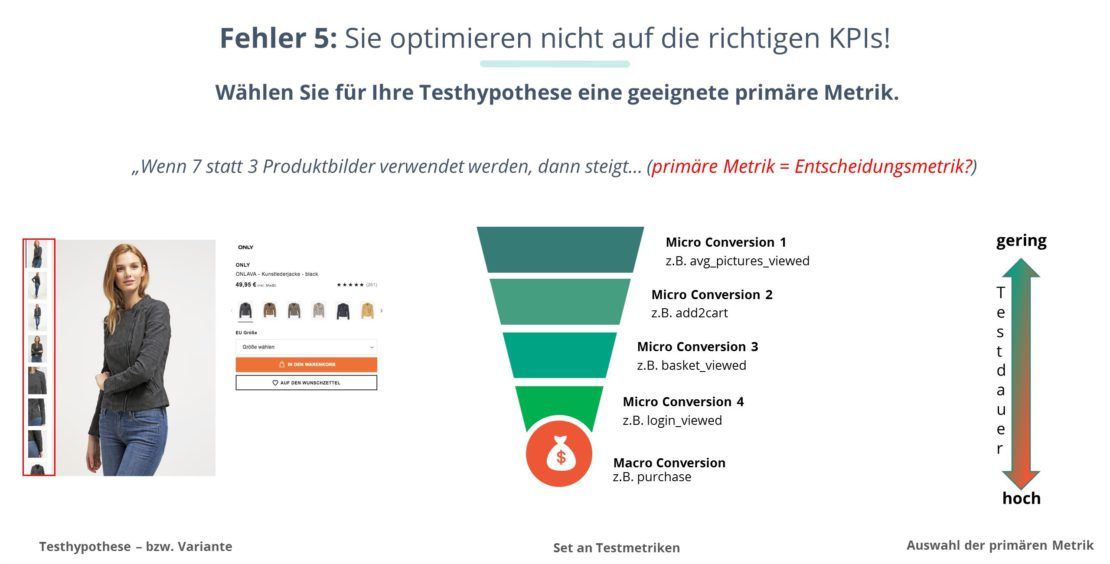

4) Beim Test werden die falschen KPI gemessen

Beim A/B Testing werden Conversions gemessen. Soweit, so gut. Aber welche Conversion wird ermittelt und bestimmt damit den Sieger des Tests? Die Frage ist nicht immer ganz einfach zu beantworten. Als Beispiel dafür dient im Webinar ein Test mit einer Produktdetailseite, die drei Produktbilder enthält. Die Testvariante wird dagegen mit sieben Produktbildern bestückt. Was wird nun als relevante Conversion definiert?

- Geht es um die Zahl der Seitenbesucher, die mit den Produktbildern interagieren?

- Ist die Zahl derer relevant, die das Produkt mit „add to card“ dem Warenkorb hinzufügen?

- Geht es um die Anzahl der potenziellen Kunden, die die Warenkorbseite ansteuern?

- Ist die Zahl derjenigen Besucher der Seite, die den Checkout erreichen, die entscheidende Größe?

- Oder geht es gar um diejenigen, die die Bestellung am Ende abschließen?

Nicht alle hier definierten Conversions besitzen denselben Stellenwert. Die Interaktion mit den Bildern ist weniger wichtig als die Zahl derer, die die Warenkorbseite erreichen. Und diese Zahl ist wiederum unwichtiger als die derjenigen, die eine Bestellung abschließen.

Ginge es alleine um die Wichtigkeit der KPI, wäre die Entscheidung also klar. Aber es gibt noch einen anderen Aspekt: die notwendige Dauer der Tests.

Die Bestellung liegt in der Reise des potenziellen Kunden durch den Onlineshop viel weiter hinten als etwa ein „add to card“. Deshalb wird höchstwahrscheinlich auch die Anzahl der Conversions geringer ausfallen. Das bedeutet nicht zuletzt: Die nötige Testdauer, um valide Testergebnisse zu erhalten, steigt an. Und je länger ein Test dauert, desto größer wird das Risiko von Störfaktoren, die das Testergebnis verfälschen.

Auch das gilt es zu berücksichtigen und dann ist nicht mehr unbedingt die bedeutendste Conversion die richtige Wahl. Im oben genannten Fall rät das Webinar beispielsweise zum „add to card“ als diejenige Conversion, die am Ende den Sieger kürt.

5) Man lässt sich durch (zu) kleine Erfolge frustieren

Wer eine bisher nicht optimierte Website optimiert, wird am Anfang oft mit großen Uplifts belohnt. Die Conversion-Rate lag bei X% und steigt immens um Y% an. Der zweite und der dritte Test verläuft möglicherweise ähnlich. Man wird verwöhnt durch solche Anstiege. Und wenn dann irgendwann nur noch relativ kleine Steigerungen folgen, wird man bisweilen so frustriert, dass man die Tests ganz stoppt. Das Problem bei der Sache? Es ist nahezu sicher, dass die Steigerungen irgendwann geringer ausfallen.

Es ist wie beim Spitzensport: Je besser man wird, desto mehr muss man selbst um kleine Leistungsanstiege hart kämpfen. Eine Ausnahme gibt es in der Conversion-Optimierung bisweilen beim Blick auf Segmente. Wer bisher die Gesamtheit aller Besucher einer zu testenden Seite X im Auge hatte und nun nur noch kleine Steigerungen der Conversion-Rate registriert, könnte bei der Optimierung für ein bestimmtes Kundensegment plötzlich wieder kräftige Anstiege verzeichnen.

Aber darum geht es letztlich gar nicht: Conversion-Optimierung lohnt sich nämlich selbst bei kleinen Erfolgen. Eine gute Conversion-Optimierung mag als Sprint beginnen. Im Prinzip ist sie aber immer ein Langlauf. Und dabei wird es Etappen geben, die die Conversion-Rate kaum steigern, die ermüdend wirken, aber a) selbst sie bringen einen Erkenntnisgewinn und b) auch viele kleine Steigerungen der Conversion-Rate machen sich am Ende als verbesserte Performance bemerkbar.

Ebenfalls ein Thema: Einflussfaktoren auf das A/B-Testing

Im Webinar geht es um zwei weitere Fehler: um Tests ohne Prozesse und Roadmaps sowie um den Verzicht auf ein permanentes Testing. Darüber hinaus wird beispielsweise erläutert, welche Voraussetzungen für erfolgreiche A/B Tests gegeben sein müssen und welche Faktoren Einfluss auf die Validität eines A/B Tests haben. Ein weiteres Thema ist die Frage, warum A/B Tests bei manchen Websites nicht funktionieren und wie in solch einem Fall die Alternative aussieht.

Das Webinar „Die 7 größten Fehler bei A/B-Tests“ gehört zur ConversionBoosting Wissensdatenbank mit einer Fülle an kostenlosen Inhalten rund um die Conversion-Optimierung.