Die Anzahl von Tests mit einem eher unklaren Ausgang ist bei vielen Testings relativ hoch. Solche Tests als Ausschuss zu interpretieren und keines weiteren Blickes zu würdigen, wäre deshalb schade. Bevor man sie ad acta legt, sollte man lieber nochmals genau hinsehen, ob sich nicht doch wertvolle Erkenntnisse aus ihnen ziehen lassen. Oft ist das der Fall.

Manchmal steckt das Interessanteste im Detail

Man schaut auf die Originalseite „A“ und die Testvariante „B“ und es zeigt sich beim Blick auf die Gesamtheit aller Testteilnehmer kein Sieger. Dann kann es aber immer noch sein, dass sich eine der beiden Varianten in einem Segment als klarer Favorit zeigt. Vielleicht schneidet Variante B ja bei Kunden mit einem Tablet viel besser ab als bei den PC-Nutzern? Dann sollte man überlegen, ob man seine Strategie fürs mobile Internet verändert und im Rahmen von Responsive Webdesign Variante B zum Standard für Tabletnutzer erhebt.

Zugleich sollte man sich klar machen: Wenn die Varianten A und B allgemein gleich stark sind, Variante B aber bei Tabletnutzern zu signifikant mehr Conversions führt, wird es vermutlich irgendwo einen Ausgleichsfall geben, bei dem stattdessen die Originalvariante „A“ die deutlich erfolgreichere ist. Die Suche danach kann weitere wertvolle Erkenntnisse liefern.

Es gibt zahlreiche mögliche Segmentierungen

Vielleicht ist Variante B erfolgreicher bei Frauen oder Männern, bei älteren oder aber jüngeren Besuchern? Vielleicht erreicht Variante B bei potenziellen Neukunden eine höhere Conversion-Rate, während die Conversion-Rate bei angemeldeten Bestandskunden sogar sinkt. Oder es ist genau umgekehrt. Und vielleicht gibt es klare Unterschiede zwischen Besuchern, die über Bannerwerbung auf die Seite kommen, und denen, die die Seite über ein organisches Suchergebnis auf Google erreichen. Der Blick auf die Segmente kann zu wertvollen Ideen für weitere Tests führen. Ein Beispiel:

Für einen A/B Test eines Spezialonlineshops mit Produkten für eine Trendsportart wird eine Version einer Seite mit etwas größerer Schriftart entwickelt. Beim Testing zeigen sich keine signifikanten Unterschiede zwischen den Conversion-Rates.

Der Blick auf die Details verrät aber, dass Seitenvariante B bei der relativ kleinen Gruppe der älteren Besucher durchaus eine signifikant höhere Conversion-Rate aufweist. Der Unterschied zur Originalversion A ist nicht riesig, aber durchaus bemerkenswert, zumal die Conversion-Rate bei den jüngeren Besuchern der Seitenvariante B sogar etwas sinkt.

Im Beispiel könnte man unter anderem überlegen, ob es sich lohnen könnte, älteren oder auch sehbehinderten jüngeren Besuchern mit einem Button den Wechsel auf eine Seite mit größerer Schriftart zu ermöglichen.

Ganz allgemein könnte der Test dazu führen, verstärkt über das Thema Barrierefreiheit der Website nachzudenken, um bestimmte Besuchersegmente zu mehr Conversions zu bewegen. Hätte man nur das Gesamtergebnis gesehen und den A/B Test dann ignoriert, wären möglicherweise wertvolle Erkenntnisse verlorengegangen.

Micro-Conversions können wichtig sein. Retouren auch.

Wer nur das Gesamtergebnis eines A/B Tests im Blick hat, ignoriert eventuell Micro-Conversions, die ebenfalls wichtig sein können. Solche Micro-Conversions können sogar dafür sorgen, dass sich bei den gleichstark wirkenden Varianten A und B am Ende doch noch ein Sieger herauskristallisiert.

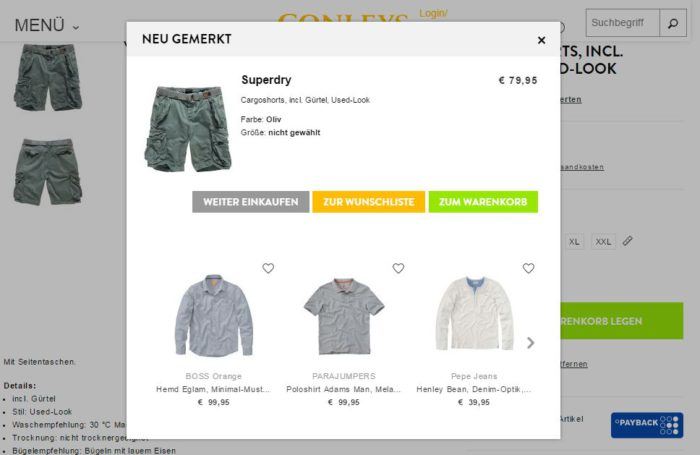

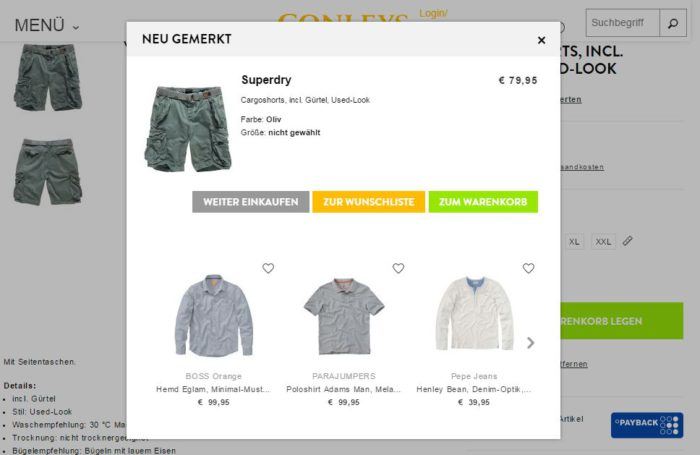

Vielleicht haben ja bei der Variante B der Produktdetailseite eines Onlineshops signifikant mehr Besucher das Produkt auf die Wunschliste oder den Merkzettel gesetzt? Dann könnte man prüfen, wie viele der Testteilnehmer das dort platzierte Produkt bei einer späteren Sitzung doch noch gekauft haben und ob sich durch eine hohe Zahl solcher „Spätkäufer“ bei der Testversion B indirekt doch eine signifikant höhere Conversion-Rate ergeben hat.

Vielleicht haben sich auch signifikant mehr Menschen dafür entschieden, dem Onlineshop künftig bei Facebook zu folgen. Wenn bei den Conversions (hier: Käufen) kein eindeutiger Gewinner existiert, gibt es vielleicht bei Micro-Conversions einen? Umgekehrt kann es sein, dass es sich bei zwei gleichstarken Varianten einer Onlineshop-Seite eine als diejenige erweist, die viel mehr Kunden mit hoher Retourenrate anlockt. Dann erweist sich diese im Nachhinein vielleicht doch als diejenige, die weniger Umsatz generiert.

Ist die Hypothese eine Modifizierung wert?

Viele begraben mit einem Test ohne klares Ergebnis die dem Test zugrundeliegende Hypothese gleich mit, ohne sich nochmals mit ihr zu beschäftigen. Ganz so einfach sollte man sich die Sache aber nicht machen. Vielleicht geht die Hypothese ja doch in die richtige Richtung, wurde durch den Test aber nur unzureichend überprüft oder sollte vielleicht modifiziert nochmals als Grundlage für Tests dienen. Wiederum ein Beispiel:

Die einem Test zugrundeliegende Hypothese lautet „Die Seite X ist übervoll mit Seitenelementen und eine Reduzierung der Elemente steigert die Conversion-Rate“. In einem A/B Test tritt daher eine Seitenvariante mit weniger Elementen gegen die Originalversion an. Allerdings schneidet Variante B weder besser noch schlechter als das Original ab.

Die Hypothese ist also widerlegt. Wirklich? Vielleicht war die durchgeführte Veränderung an der Seite ja einfach nicht radikal genug, um auf die Conversion-Rate zu wirken. Dann lohnt sich eventuell ein zweiter Test mit einer Variante B, die im Vergleich zu vorherigen nochmals deutlich abspeckt. Vielleicht hat die Reduzierung für den A/B Test auch einfach die falschen Seitenelemente getroffen? Dann sollte man sich bei einem weiteren Test eventuell auf die Halbierung des Textes konzentrieren, während man beim durchgeführten Test die Anzahl der Bilder auf der Seite reduziert und die übrigbleibenden Bilder verkleinert hat. Wie man nach einem ergebnislosen A/B Test mit der Hypothese umgeht, lässt sich nur im Einzelfall entscheiden.

Kein A/B Test ist wertlos

Selbst, wenn nach eingehender Prüfung klar wird, dass sowohl der A/B Test als auch die Hypothese verworfen werden sollten, war der A/B Test nicht wertlos. Tests dienen nicht alleine dazu, die Conversion-Rate einer Seite zu verbessern. Jeder Test sollte darüber hinaus einen Lerneffekt haben. Und wenn man lernt, wie etwas nicht funktioniert, und den fehlgeschlagenen Ansatz dann nicht weiter verfolgt, nähert man sich im Ausschlussverfahren erfolgreichen Veränderungen. Wichtig ist deshalb nach jedem A/B Test zumindest eine kurze Phase der Evaluation. In ihr sollte man unter anderem klären, welche A/B Tests sich nach dem Test mit dem uneindeutigen Ausgang als sinnvolle Folgetests anbieten. Jeder A/B Test bringt einen weiter. Das zu erkennen, ist ein wichtiger Schritt für besseres A/B Testing.

Der Autor

Julian Kleinknecht

Geschäftsführer & Gründer

Julian Kleinknecht hat viele Jahre Erfahrung in den Bereichen Web-Analyse und A/B-Testing und teilt sein Wissen oft bei LinkedIn.

Jede Woche neue Tipps & Inspirationen zu Conversion-Optimierung und -Tracking.